梯度下降法

作者:追风剑情 发布于:2022-5-24 9:35 分类:Algorithms

应用数学最重要的任务之一就是寻找函数取最小值的点。梯度下降法是神经网络中找函数最小值的点的方法。在数值分析领域,梯度下降法也称为最速下降法。

通过导数找函数最小值

例 1 已知函数 z=f(x,y),求使函数取得最小值的 x、y ?

解 分别对x、y求偏导数,当x、y的偏导数都为0时,函数 z=f(x,y) 取得最小值。

$$\frac{\partial{f(x,y)}}{\partial{x}}=0,\quad\frac{\partial{f(x,y)}}{\partial{y}}=0$$

上式表明,与函数相切的平面变得水平时,那个切点即为函数的最小值点。

注意 上式只是寻找最小值点的必要条件,对于有多个极值点的函数要小心处理。

在神经网络中变量非常多,通常不采用联立偏导方程组求解。

梯度下降法的基本思路

先在函数上随便取一个点,然后向最陡的方向移动一小段距离,再次判断最陡的方向,然后再向最陡的方向移动一小段距离,不断重复这种操作,便可沿最短路径到达函数底部(最小值点)。

例 2 函数z=f(x,y)中,当x改变△x,y改变△y时,函数f(x,y)的值的变化△z?

解 根据近似公式,以下关系式成立。 $$\Delta{z}=f(x+\Delta{x},y+\Delta{y})-f(x,y)=\frac{\partial{f(x,y)}}{\partial{x}}\Delta{x}+\frac{\partial{f(x,y)}}{\partial{y}}\Delta{y}$$ 可以将上式表示为两个向量的内积形式 $$\left(\frac{\partial{f(x,y)}}{\partial{x}},\frac{\partial{f(x,y)}}{\partial{y}}\right),\quad(\Delta{x},\Delta{y})$$ 当两个向量的方向相反时,这两个向量的内积取得最小值,根据向量的这条性质得 $$(\Delta{x},\Delta{y})=-η\left(\frac{\partial{f(x,y)}}{\partial{x}},\frac{\partial{f(x,y)}}{\partial{y}}\right)\quad(η为正的微小常数)$$ 注:希腊字母η读作ita

向量$(\Delta{x},\Delta{y})$称为位移向量。向量$\left(\frac{\partial{f(x,y)}}{\partial{x}},\frac{\partial{f(x,y)}}{\partial{y}}\right)$称为函数f(x,y)在点(x,y)处的梯度(gradient)。梯度给出了最陡的坡度方向。

将上面的公式推广到n个变量 $$(\Delta{x_1},\Delta{x_2},\cdots,\Delta{x_n})=-η\left(\frac{\partial{f}}{\partial{x_1}},\frac{\partial{f}}{\partial{x_2}},\cdots,\frac{\partial{f}}{\partial{x_n}}\right)$$ 神经网络中会涉及到成千上万个变量,用上面的式子表示就显得十分冗长。

更简洁的表达式 $$ \begin{aligned} \Delta{x}&=(\Delta{x_1},\Delta{x_2},\cdots,\Delta{x_n})\\ \nabla{f}&=\left(\frac{\partial{f}}{\partial{x_1}},\frac{\partial{f}}{\partial{x_2}},\cdots,\frac{\partial{f}}{\partial{x_n}}\right) \end{aligned} $$ $\nabla$在向量分析领域,称为哈密顿算子。

注:希腊字母$\nabla$读作nabla

利用上面的$\Delta{x}$和$\nabla{f}$,梯度下降法的基本公式可以简洁地表示为 $$\Delta{x}=-η\nabla{f}$$

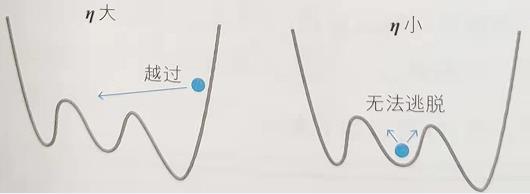

η可以看作移动的“步长”,根据η的值,可以确定下一步移动到哪个点。如果步长较大,那么可能会到达最小值点,也可能会直接跨过了最小值点(左图)。而如果步长较小,则可能会滞留在极小值点(右图)。

在神经网络中,η称为学习率。遗憾的是,它的确定方法没有明确的标准,只能通过反复试验来寻找恰当的值。

η与步长

上面的讨论是将η看作步长,实际上这并不正确,正确的做法应该是将整个右侧看作步长$-η\left(\frac{\partial{f}}{\partial{x_1}},\frac{\partial{f}}{\partial{x_2}},\cdots,\frac{\partial{f}}{\partial{x_n}}\right)$,为了让“步长”均匀,需要将梯度修正为单位向量,如下: $$(\Delta{x},\Delta{y})=-η\left(\frac{\partial{f(x,y)}}{\partial{x}},\frac{\partial{f(x,y)}}{\partial{y}}\right)\biggl{/}\sqrt{ \left(\frac{\partial{f(x,y)}}{\partial{x}}\right)^2+\left(\frac{\partial{f(x,y)}}{\partial{y}}\right)^2}$$ 经过以上修正后,就可以将η看作步长了。

单变量函数的梯度下降法

梯度下降法也可以用于单变量函数,将偏导数替换为导数,将得到的下式作为梯度下降法的基本公式。 $$\Delta{x}=-ηf'(x)\quad(η为正的微小常数)$$

验证梯度下降法

例 对于函数$z=x^2+y^2$,请用梯度下降法求出使函数取得最小值的x、y值

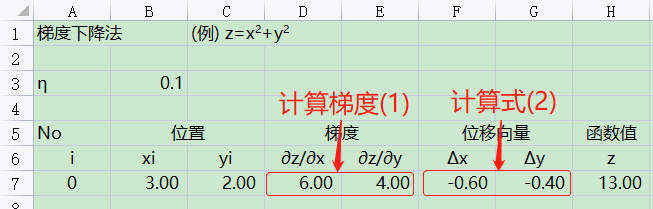

解 首先求出梯度 $$梯度\quad \left(\frac{\partial{z}}{\partial{x}}, \frac{\partial{z}}{\partial{y}}\right)=(2x, 2y)\tag{1}$$

接下来,逐步进行计算。

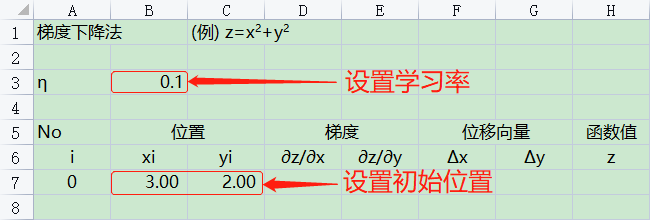

① 初始设定

随便给出初始位置$(x_i,y_i)(i=0)$与学习率η。

② 计算位移向量

对于当前位置$(x_i,y_i)$,算出梯度,然后根据梯度下降法的基本公式,求位移向量$\Delta{x}=(\Delta{x_i},\Delta{y_i})$,根据(1)式可得 $$(\Delta{x_i},\Delta{y_i})=-η(2x_i,2y_i)=(-η \cdot 2x_i,-η \cdot 2y_i)\tag{2}$$

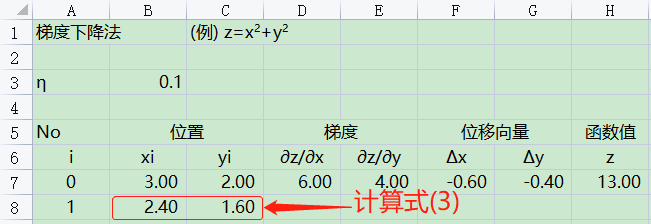

③ 更新位置

根据梯度下降法,由下式求出从当前位置$(x_i,y_i)$移动到点$(x_{i+1},y_{i+1})$。 $$(x_{i+1},y_{i+1})=(x_i,y_i)+(\Delta{x_i},\Delta{y_i})\tag{3}$$

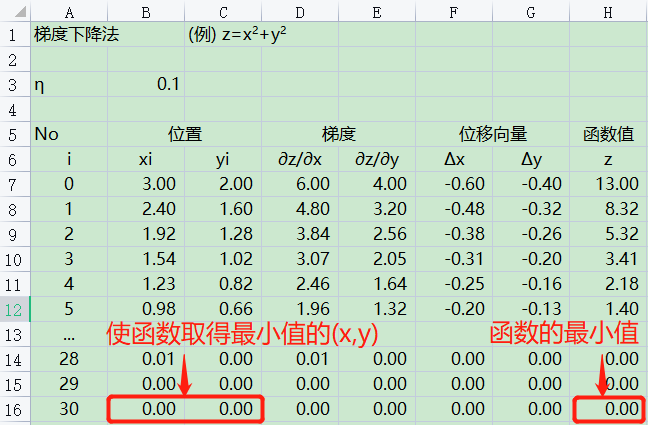

④ 反复执行②~③的操作

下图是反复执行②~③的操作30次后得出的坐标$(x_{30},y_{30})$的值。

与建立偏导方程组求解出的值一致。 $$偏导方程组\quad \begin{equation} \left\{ \begin{aligned} \frac{\partial{z}}{\partial{x}}=2x=0 \\ \frac{\partial{z}}{\partial{y}}=2y=0 \end{aligned} \right. \end{equation} $$ 解偏导方程组得,x=0,y=0

标签: Algorithms

日历

最新文章

随机文章

热门文章

分类

存档

- 2026年1月(5)

- 2025年12月(1)

- 2025年11月(1)

- 2025年9月(3)

- 2025年7月(4)

- 2025年6月(5)

- 2025年5月(1)

- 2025年4月(5)

- 2025年3月(4)

- 2025年2月(3)

- 2025年1月(1)

- 2024年12月(5)

- 2024年11月(5)

- 2024年10月(5)

- 2024年9月(3)

- 2024年8月(3)

- 2024年7月(11)

- 2024年6月(3)

- 2024年5月(9)

- 2024年4月(10)

- 2024年3月(11)

- 2024年2月(24)

- 2024年1月(12)

- 2023年12月(3)

- 2023年11月(9)

- 2023年10月(7)

- 2023年9月(2)

- 2023年8月(7)

- 2023年7月(9)

- 2023年6月(6)

- 2023年5月(7)

- 2023年4月(11)

- 2023年3月(6)

- 2023年2月(11)

- 2023年1月(8)

- 2022年12月(2)

- 2022年11月(4)

- 2022年10月(10)

- 2022年9月(2)

- 2022年8月(13)

- 2022年7月(7)

- 2022年6月(11)

- 2022年5月(18)

- 2022年4月(29)

- 2022年3月(5)

- 2022年2月(6)

- 2022年1月(8)

- 2021年12月(5)

- 2021年11月(3)

- 2021年10月(4)

- 2021年9月(9)

- 2021年8月(14)

- 2021年7月(8)

- 2021年6月(5)

- 2021年5月(2)

- 2021年4月(3)

- 2021年3月(7)

- 2021年2月(2)

- 2021年1月(8)

- 2020年12月(7)

- 2020年11月(2)

- 2020年10月(6)

- 2020年9月(9)

- 2020年8月(10)

- 2020年7月(9)

- 2020年6月(18)

- 2020年5月(4)

- 2020年4月(25)

- 2020年3月(38)

- 2020年1月(21)

- 2019年12月(13)

- 2019年11月(29)

- 2019年10月(44)

- 2019年9月(17)

- 2019年8月(18)

- 2019年7月(25)

- 2019年6月(25)

- 2019年5月(17)

- 2019年4月(10)

- 2019年3月(36)

- 2019年2月(35)

- 2019年1月(28)

- 2018年12月(30)

- 2018年11月(22)

- 2018年10月(4)

- 2018年9月(7)

- 2018年8月(13)

- 2018年7月(13)

- 2018年6月(6)

- 2018年5月(5)

- 2018年4月(13)

- 2018年3月(5)

- 2018年2月(3)

- 2018年1月(8)

- 2017年12月(35)

- 2017年11月(17)

- 2017年10月(16)

- 2017年9月(17)

- 2017年8月(20)

- 2017年7月(34)

- 2017年6月(17)

- 2017年5月(15)

- 2017年4月(32)

- 2017年3月(8)

- 2017年2月(2)

- 2017年1月(5)

- 2016年12月(14)

- 2016年11月(26)

- 2016年10月(12)

- 2016年9月(25)

- 2016年8月(32)

- 2016年7月(14)

- 2016年6月(21)

- 2016年5月(17)

- 2016年4月(13)

- 2016年3月(8)

- 2016年2月(8)

- 2016年1月(18)

- 2015年12月(13)

- 2015年11月(15)

- 2015年10月(12)

- 2015年9月(18)

- 2015年8月(21)

- 2015年7月(35)

- 2015年6月(13)

- 2015年5月(9)

- 2015年4月(4)

- 2015年3月(5)

- 2015年2月(4)

- 2015年1月(13)

- 2014年12月(7)

- 2014年11月(5)

- 2014年10月(4)

- 2014年9月(8)

- 2014年8月(16)

- 2014年7月(26)

- 2014年6月(22)

- 2014年5月(28)

- 2014年4月(15)

友情链接

- Unity官网

- Unity圣典

- Unity在线手册

- Unity中文手册(圣典)

- Unity官方中文论坛

- Unity游戏蛮牛用户文档

- Unity下载存档

- Unity引擎源码下载

- Unity服务

- Unity Ads

- wiki.unity3d

- Visual Studio Code官网

- SenseAR开发文档

- MSDN

- C# 参考

- C# 编程指南

- .NET Framework类库

- .NET 文档

- .NET 开发

- WPF官方文档

- uLua

- xLua

- SharpZipLib

- Protobuf-net

- Protobuf.js

- OpenSSL

- OPEN CASCADE

- JSON

- MessagePack

- C在线工具

- 游戏蛮牛

- GreenVPN

- 聚合数据

- 热云

- 融云

- 腾讯云

- 腾讯开放平台

- 腾讯游戏服务

- 腾讯游戏开发者平台

- 腾讯课堂

- 微信开放平台

- 腾讯实时音视频

- 腾讯即时通信IM

- 微信公众平台技术文档

- 白鹭引擎官网

- 白鹭引擎开放平台

- 白鹭引擎开发文档

- FairyGUI编辑器

- PureMVC-TypeScript

- 讯飞开放平台

- 亲加通讯云

- Cygwin

- Mono开发者联盟

- Scut游戏服务器引擎

- KBEngine游戏服务器引擎

- Photon游戏服务器引擎

- 码云

- SharpSvn

- 腾讯bugly

- 4399原创平台

- 开源中国

- Firebase

- Firebase-Admob-Unity

- google-services-unity

- Firebase SDK for Unity

- Google-Firebase-SDK

- AppsFlyer SDK

- android-repository

- CQASO

- Facebook开发者平台

- gradle下载

- GradleBuildTool下载

- Android Developers

- Google中国开发者

- AndroidDevTools

- Android社区

- Android开发工具

- Google Play Games Services

- Google商店

- Google APIs for Android

- 金钱豹VPN

- TouchSense SDK

- MakeHuman

- Online RSA Key Converter

- Windows UWP应用

- Visual Studio For Unity

- Open CASCADE Technology

- 慕课网

- 阿里云服务器ECS

- 在线免费文字转语音系统

- AI Studio

- 网云穿

- 百度网盘开放平台

- 迅捷画图

- 菜鸟工具

- [CSDN] 程序员研修院

- 华为人脸识别

- 百度AR导航导览SDK

- 海康威视官网

- 海康开放平台

- 海康SDK下载

- git download

- Open CASCADE

- CascadeStudio

交流QQ群

-

Flash游戏设计: 86184192

Unity游戏设计: 171855449

游戏设计订阅号